George Teixeira è un manager di lunga esperienza nel settore dello storage enterprise. Da anni è a capo di Datacore Software e in qualità di Ceo con passione porta in giro per il mondo il proprio credo relativo alle performance dello storage. Affabile e paziente, si mette a disposizione di chi ha di fronte per capire quali sono i dubbi e per chiarli. Noi ne abbiamo approfittato anche stavolta e gli abbiamo posto tre questioni: come si fa a capire se lo storage di cui si dispone è adeguato al proprio business; quali sono i parametri per misurare le performance; cosa si deve fare per arrivare ad avere uno storage performante. Ecco cosa ci ha risposto.

Indichiamo ai CIO italiani quali sono i fattori tecnici da considerare per capire se il proprio storage è sufficiente per il proprio business?

La velocità con cui oggi si lavora sta trasformando il datacenter, e la pressione per far fronte al cambiamento e alla crescita non è mai stata così forte. Per rispondere alle esigenze dei clienti, le aziende si trovano sempre più spesso davanti alla sfida di erogare su richiesta applicazioni e servizi It.

Tra gli elementi chiave da considerare ci sono la flessibilità software per rispondere al cambiamento e proteggere gli investimenti già realizzati; le prestazioni che garantiscano il rispetto degli accordi sul livello di servizio e velocizzino le decisioni e le transazioni indispensabili a gestire le applicazioni aziendali e quelle di primo livello; la necessità di offrire modalità semplici ed efficaci per gestire la diversità di modelli e dispositivi di storage oggi disponibili sul mercato: e l’esigenza di fornire le funzionalità necessarie ad automatizzare e proteggere una risorsa aziendale critica: i dati.

Prima di tutto penso sia importante capire che a definire l’infrastruttura di storage sono il software e le applicazioni aziendali: la maggior parte dei CIO pensa ancora troppo a dispositivi hardware proprietari o a specifici marchi invece che all’agilità del software. Il Software-defined Storage e i server di marca pre-configurati dai principali fornitori permettono di ottenere una flessibilità molto superiore nella realizzazione di infrastrutture di storage capaci di scalare e di rispondere ai cambiamenti e alle future esigenze.

Per molte organizzazioni lo storage è implementato con differenti approcci e diversi modelli (per esempio SAN Block, NAS File, Object), fornitori, strumenti e software di gestione; in più bisogna cercare di capirne l’insieme di batterie All-flash, sistemi iper-convergenti e storage Cloud. Anche le tipologie di informazione stanno cambiando, con dati strutturati e non, database orientati alle transazioni, big data e l’Internet of Things.

Secondo, quando si parla di prestazioni non si fa più riferimento solo alle transazioni, ma anche alla velocità con cui i sistemi possono rispondere: troppo spesso è lo storage il collo di bottiglia per il progresso.

Terzo, lo storage non significa più solo batterie di dischi stand-alone, ma l’insieme dei dati aziendali e la loro gestione attraverso reti e combinazioni di dispositivi, batterie, server e anche memorie. Il problema è che la maggior parte dei fornitori offre una soluzione diversa per ciascuna di queste tipologie, mentre un CIO vuole semplicità e gestione comune per evitare i molti “silo”, i costi di gestione e l’esperienza necessari per tenere il passo con tutte queste diverse soluzioni specializzate.

Tutti questi elementi portano a complessità e costi elevati, evidenziando i motivi per cui il Software-defined Storage sta diventando popolare.

Il vantaggio principale è quello di mettere a disposizione una soluzione flessibile basata sul software che può essere aggiunta con facilità a qualunque ambiente senza dover “rottamare” l’infrastruttura esistente.

E infine, ma non meno importante, la flessibilità nella protezione dei dati è critica: la capacità di proteggere i dati non solo localmente, ma anche in altre città o replicati in siti remoti su sistemi diversi, è essenziale per garantire il disaster recovery. Quando si parla di soluzioni di storage, un’altra considerazione importante da fare riguarda il software capace di automatizzare e proteggere i dati offrendo disponibilità continua e accesso ai data store senza intervento umano.

Parlando di prestazioni nel mondo reale è spesso difficile ottenere informazioni paragonabili. All’inizio di quest’anno, DataCore ha commissionato a TechValidate un’indagine indipendente realizzata su quasi 2.000 dei nostri 10.000 clienti attivi. Ciò che è emerso è che oltre il 79% di loro ha visto almeno triplicare le prestazioni (i risultati sono disponibili qui).

In termini di benchmark, ogni produttore fa quello che io chiamo benchmarketing, sottolineando i risultati di test creati internamente e finalizzati a mostrare le proprie prestazioni. I CIO dovrebbero essere cauti su questo tema. Almeno nello storage, infatti, c’è un benchmark riconosciuto valido dall’intero settore che è uguale per tutti, indipendente dai produttori e certificato con risultati pubblici, in modo che gli interessati possano riprodurne le condizioni.

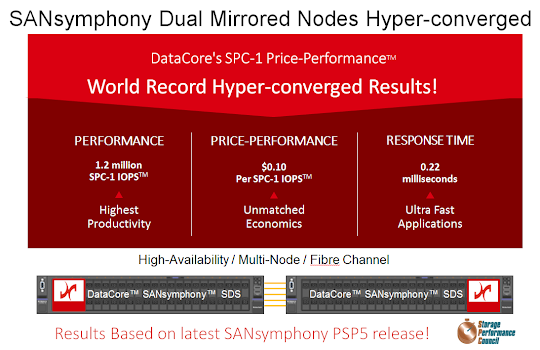

Si tratta del benchmark SPC-1 dello Storage Performance Council, in cui DataCore è leader in tutti i parametri chiave per la misurazione delle prestazioni dello storage:

Con queste informazioni si può passare a valutare le soluzioni di Software-defined Storage per assicurarsi che possano offrire non solo la necessaria flessibilità, ma anche che siano adatte a supportare gli investimenti già realizzati e che siano in grado di scalare per rispondere alle necessità legate alla crescita.

Dal punto di vista delle prestazioni, bisogna fare il proprio lavoro e chiedere delle referenze, fare delle valutazioni personali invece di credere ai risultati del “benchmarketing” e aprire la mente per esplorare nuove innovazioni come l’elaborazione parallela e i server multi-core che stanno rivoluzionando le prestazioni nel mondo dello storage.

È inutile comprare un altro box di storage dallo stesso tradizionale produttore che non comprende veramente il ruolo del software e di come questo stia ridefinendo il mondo dello storage.

Tra gli elementi chiave da considerare ci sono la flessibilità software per rispondere al cambiamento e proteggere gli investimenti già realizzati; le prestazioni che garantiscano il rispetto degli accordi sul livello di servizio e velocizzino le decisioni e le transazioni indispensabili a gestire le applicazioni aziendali e quelle di primo livello; la necessità di offrire modalità semplici ed efficaci per gestire la diversità di modelli e dispositivi di storage oggi disponibili sul mercato: e l’esigenza di fornire le funzionalità necessarie ad automatizzare e proteggere una risorsa aziendale critica: i dati.

Prima di tutto penso sia importante capire che a definire l’infrastruttura di storage sono il software e le applicazioni aziendali: la maggior parte dei CIO pensa ancora troppo a dispositivi hardware proprietari o a specifici marchi invece che all’agilità del software. Il Software-defined Storage e i server di marca pre-configurati dai principali fornitori permettono di ottenere una flessibilità molto superiore nella realizzazione di infrastrutture di storage capaci di scalare e di rispondere ai cambiamenti e alle future esigenze.

Per molte organizzazioni lo storage è implementato con differenti approcci e diversi modelli (per esempio SAN Block, NAS File, Object), fornitori, strumenti e software di gestione; in più bisogna cercare di capirne l’insieme di batterie All-flash, sistemi iper-convergenti e storage Cloud. Anche le tipologie di informazione stanno cambiando, con dati strutturati e non, database orientati alle transazioni, big data e l’Internet of Things.

Secondo, quando si parla di prestazioni non si fa più riferimento solo alle transazioni, ma anche alla velocità con cui i sistemi possono rispondere: troppo spesso è lo storage il collo di bottiglia per il progresso.

Terzo, lo storage non significa più solo batterie di dischi stand-alone, ma l’insieme dei dati aziendali e la loro gestione attraverso reti e combinazioni di dispositivi, batterie, server e anche memorie. Il problema è che la maggior parte dei fornitori offre una soluzione diversa per ciascuna di queste tipologie, mentre un CIO vuole semplicità e gestione comune per evitare i molti “silo”, i costi di gestione e l’esperienza necessari per tenere il passo con tutte queste diverse soluzioni specializzate.

Tutti questi elementi portano a complessità e costi elevati, evidenziando i motivi per cui il Software-defined Storage sta diventando popolare.

Il vantaggio principale è quello di mettere a disposizione una soluzione flessibile basata sul software che può essere aggiunta con facilità a qualunque ambiente senza dover “rottamare” l’infrastruttura esistente.

E infine, ma non meno importante, la flessibilità nella protezione dei dati è critica: la capacità di proteggere i dati non solo localmente, ma anche in altre città o replicati in siti remoti su sistemi diversi, è essenziale per garantire il disaster recovery. Quando si parla di soluzioni di storage, un’altra considerazione importante da fare riguarda il software capace di automatizzare e proteggere i dati offrendo disponibilità continua e accesso ai data store senza intervento umano.

Quali sono i parametri di valutazione per misurare la performance dello storage?

Ovviamente l’ideale è registrare le prestazioni nel mondo reale. In DataCore siamo molto focalizzati sulle prestazioni e siamo i leader mondiali nelle performance dello storage registrate tramite benchmark scientifici, indipendenti e certificati.Parlando di prestazioni nel mondo reale è spesso difficile ottenere informazioni paragonabili. All’inizio di quest’anno, DataCore ha commissionato a TechValidate un’indagine indipendente realizzata su quasi 2.000 dei nostri 10.000 clienti attivi. Ciò che è emerso è che oltre il 79% di loro ha visto almeno triplicare le prestazioni (i risultati sono disponibili qui).

In termini di benchmark, ogni produttore fa quello che io chiamo benchmarketing, sottolineando i risultati di test creati internamente e finalizzati a mostrare le proprie prestazioni. I CIO dovrebbero essere cauti su questo tema. Almeno nello storage, infatti, c’è un benchmark riconosciuto valido dall’intero settore che è uguale per tutti, indipendente dai produttori e certificato con risultati pubblici, in modo che gli interessati possano riprodurne le condizioni.

Si tratta del benchmark SPC-1 dello Storage Performance Council, in cui DataCore è leader in tutti i parametri chiave per la misurazione delle prestazioni dello storage:

- Prestazioni più elevate in I/O per secondo

- Tempo di risposta più veloce/latenza più bassa

- Miglior rapporto prezzo/prestazioni

- Prestazioni elevate negli ingombri più contenuti

Unendo le due cose, quali azioni vanno fatte, in quanto tempo e in che ordine, per arrivare a disporre di un sistema performante?

Bisognerebbe prima determinare quali sono le esigenze aziendali e valutare i costi e le sfide legati al supporto delle applicazioni critiche e del loro storage, valutando anche quale tipo di crescita e cambiamenti ci si aspetta di dover affrontare non solo entro un anno, ma anche in un orizzonte temporale di 3-5 anni.Con queste informazioni si può passare a valutare le soluzioni di Software-defined Storage per assicurarsi che possano offrire non solo la necessaria flessibilità, ma anche che siano adatte a supportare gli investimenti già realizzati e che siano in grado di scalare per rispondere alle necessità legate alla crescita.

Dal punto di vista delle prestazioni, bisogna fare il proprio lavoro e chiedere delle referenze, fare delle valutazioni personali invece di credere ai risultati del “benchmarketing” e aprire la mente per esplorare nuove innovazioni come l’elaborazione parallela e i server multi-core che stanno rivoluzionando le prestazioni nel mondo dello storage.

È inutile comprare un altro box di storage dallo stesso tradizionale produttore che non comprende veramente il ruolo del software e di come questo stia ridefinendo il mondo dello storage.